Por Meghie Rodrigues

“Modelar o clima” não é o mesmo que “fazer previsões do tempo”. Os cálculos e as variáveis envolvidas para realizar as tarefas são bastante distintas, embora, em princípio, se utilizem da mesma premissa: a observação de fenômenos meteorológicos. E isto não é feito apenas a partir de estações de coleta de dados. “Aviões comerciais e navios-cruzeiro são obrigados a reportar informações como temperatura, pressão e umidade do ar. Os satélites também reportam dados do ambiente terrestre. Tudo isto alimenta os modelos climáticos e a previsão do tempo”, conta Gilvan Sampaio, pesquisador que coordena a Sub-rede de Modelagem Climática da Rede Brasileira de Pesquisas sobre Mudanças Climáticas Globais (Rede CLIMA), do Instituto Nacional de Pesquisas Espaciais (INPE).

Mais especificamente, a previsão do tempo faz-se com grande precisão em uma escala temporal curta, normalmente de poucos dias. A modelagem climática, por sua vez, se utiliza de uma escala muito mais ampla, chegando à ordem de séculos. No entanto, a impossibilidade de prever o que acontecerá em um futuro tão distante confere à modelagem climática um certo grau de incerteza – no sentido de que estes modelos podem ser validados, mas não podem ser verificados.

Não poder avançar no tempo para realizar a verificação, no entanto, não invalida os modelos: eles se valem de observações do presente e do passado (no caso dos estudos paleoclimáticos) para estabelecer seus padrões de comportamento para o futuro. “Um modelo é válido porque segue certos preceitos científicos e está substanciado por argumentos cientificamente válidos”, conta Raoni Rajão, professor de Estudos Sociais da Ciência e Tecnologia no Departamento de Engenharia de Produção da Universidade Federal de Minas Gerais (UFMG). “O que dificulta é que não dá para saber se aquilo que o modelo prevê está acontecendo ou não – simplesmente porque aquilo ainda não aconteceu”, prossegue.

Se a impossibilidade de verificação é um tema que gera debates sobre as modelagens climáticas, isso diminui substancialmente ao se tratar de previsão do tempo, já que trabalha com uma escala temporal mais reduzida. Gilvan Sampaio reitera que só é possível fazer previsão do tempo com certa precisão (cerca de 60% de acerto) em uma escala de 12 dias: “para, além disso, os meteorologistas dizem que a atmosfera torna-se caótica”.

“Caos” aqui tem o sentido concebido pelo meteorologista estadunidense Edward Lorenz que, nos anos 1960, elaborou sua teoria conhecida como “efeito borboleta”: pequenas variações na atmosfera teriam a capacidade de se multiplicar a ponto de gerar perturbações no sistema meteorológico global como um todo. Tal comportamento da atmosfera é um dos vários elementos que agregam complexidade ao trabalho de modelagem climática. Se é difícil prever o comportamento do clima para além de duas semanas, como fazer previsões para a próxima estação ou o próximo ano?

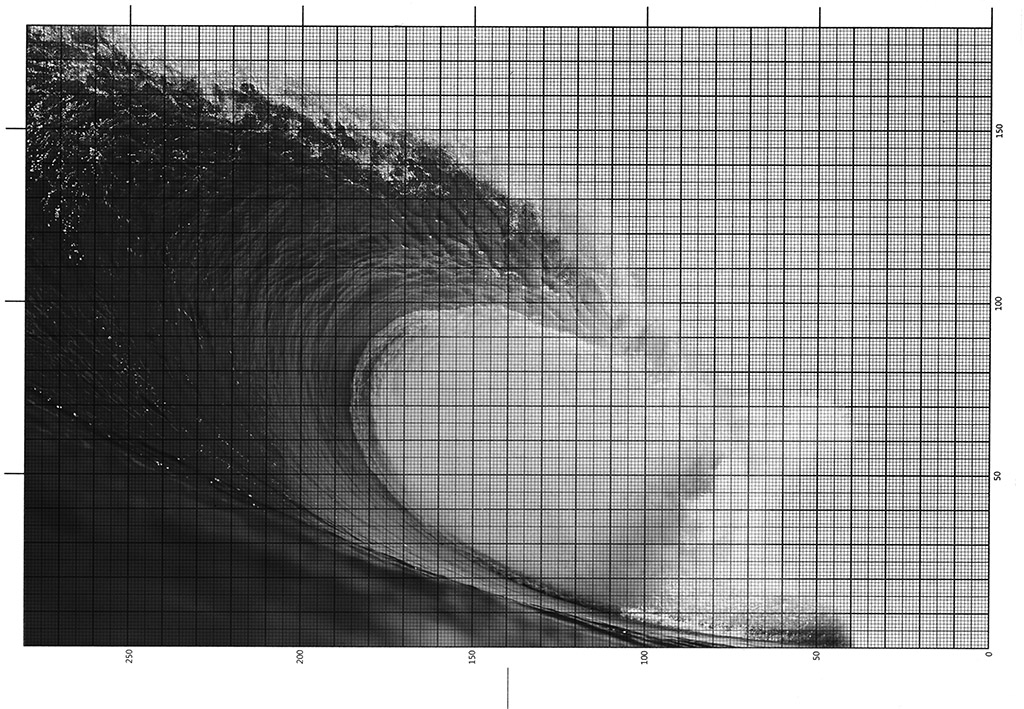

Segundo Sampaio, um dos caminhos viáveis é a observação dos oceanos, já que eles “têm uma memória muito grande do sistema climático”. Isto porque, ao contrário da atmosfera, em que fenômenos meteorológicos acontecem de forma mais veloz, os oceanos demoram mais para aquecer e resfriar. Em algumas regiões do planeta, como o Norte e Nordeste do Brasil, por exemplo, o clima é controlado pelas condições oceânicas, permitindo que previsões climáticas para além de duas semanas sejam feitas com mais precisão.

O pesquisador conta que na região semiárida, a ocorrência de chuva se deve ao que acontece nos oceanos Pacífico tropical e Atlântico tropical, enquanto que o Sudeste e Centro-oeste, por exemplo, não dependem das condições oceânicas. “Por isso é muito difícil dizer que ‘2014 será o ano mais quente da década’ ou que ‘vai chover muito na primavera’. Quem faz isso normalmente é porque está especulando no mercado. Não há como fazer previsão climática para o Sudeste e Centro-oeste do Brasil com um mês de antecedência”, completa.

Acoplar a variável oceânica à atmosférica permite uma modelagem mais acurada do clima futuro e também torna o sistema mais intrincado. De acordo com a Organização Meteorológica Mundial (OMM), agência da Organização das Nações Unidas (ONU) especializada em geofísica, os modelos climáticos utilizam a física e a química da atmosfera e dos oceanos para responder a certas perguntas sobre fenômenos possíveis e poder prever o comportamento do clima vários anos à frente.

Às variáveis atmosférica e oceânica soma-se a da superfície terrestre para se compor modelos globais de processos climáticos. Os modelos variam, ainda, em quantidade de dimensões: os que levam em conta apenas o perfil de temperatura são considerados unidimensionais (por fazer medições “verticalmente”); enquanto os que analisam processos da superfície – terrestre ou oceânica – são tidos como bidimensionais (por sua natureza “horizontal”). Os modelos tridimensionais cruzam os dois anteriores e levam em consideração um maior número de variáveis, como a radiação solar; a dinâmica de ventos e correntes marítimas; a interação entre diferentes biomas; a composição química da atmosfera; e, ainda, a resolução espaço-temporal com que estes elementos são trabalhados, já que são analisados vertical e horizontalmente no tempo.

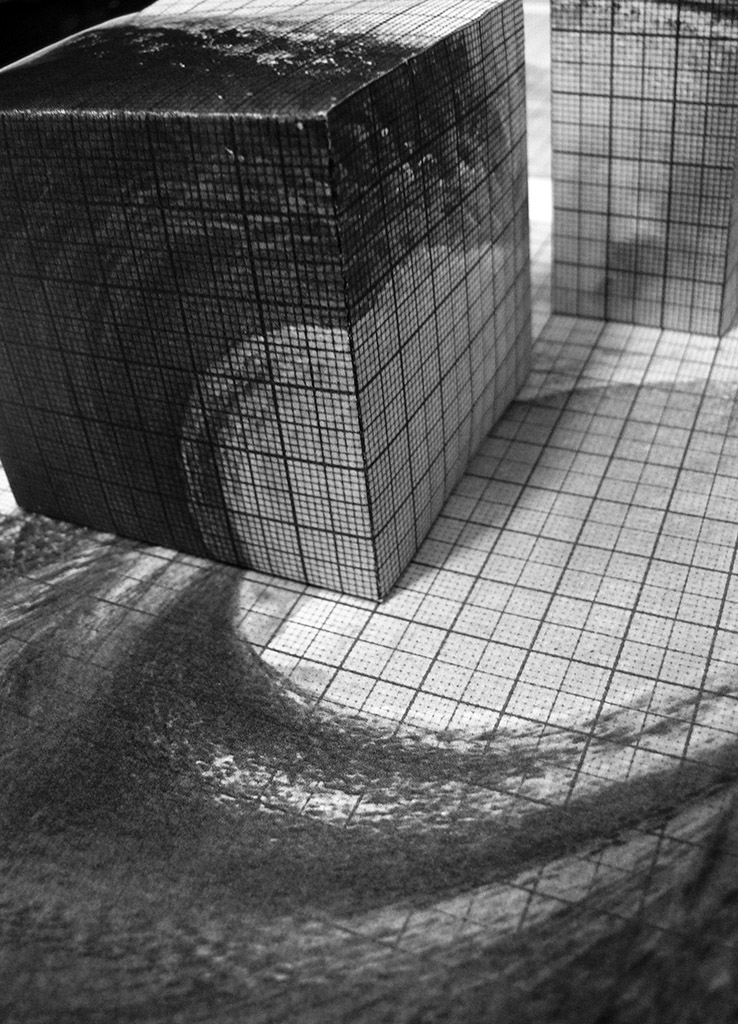

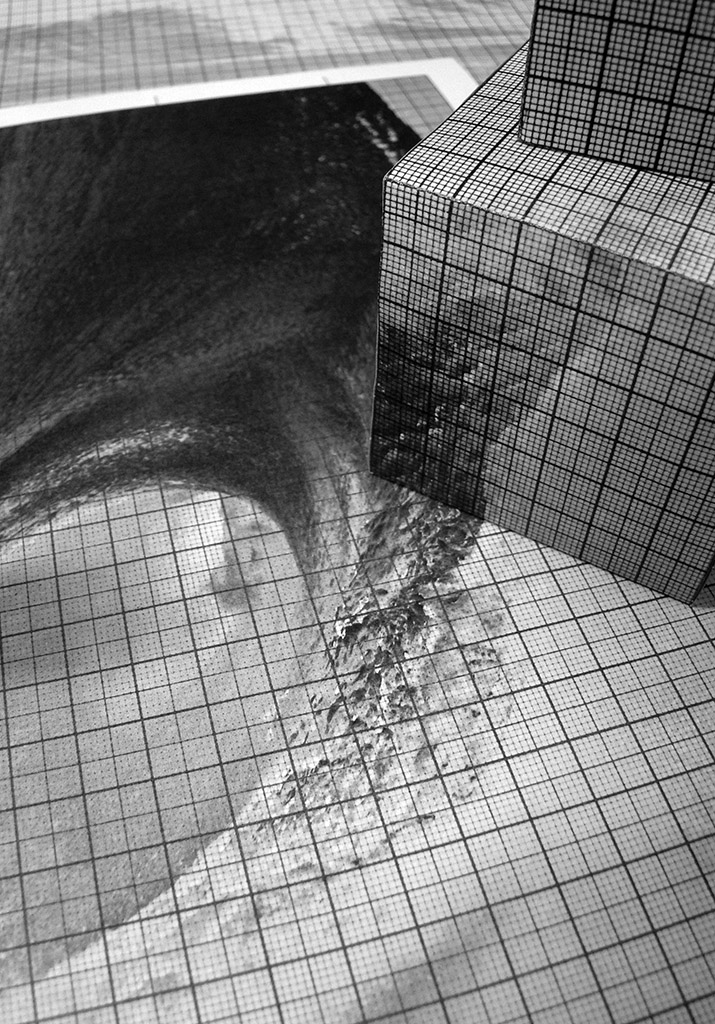

Resolução e escala são, aliás, dois aspectos que representam grande desafio para a modelagem, lembra Jean Ometto, coordenador do Centro de Ciências do Sistema Terrestre (CST) do INPE. Espacialmente falando, um modelo é composto de várias células em uma grade, ou “quadrados”, com área de dezenas ou centenas de quilômetros quadrados recortados latitude e longitudinalmente, cobrindo todo o globo terrestre.

Temporalmente, os modelos utilizam-se de “time steps”, ou intervalos de tempo, para os quais os parâmetros daquele modelo serão calculados para cada uma das células da grade. Tomando um exemplo dado pela OMM, um modelo de resolução horizontal de 100 km e vinte níveis verticais usaria, normalmente, um “time step” de 10-20 minutos – ou seja, as previsões “marcham no tempo” em passos de 10-20 minutos. Uma simulação de um ano com tal configuração precisaria processar dados por 27 mil vezes (porque um ano tem pouco mais de 26 mil “pacotes” de 20 minutos) para cada um dos 2,5 milhões de pontos, ou células, da grade (2,5 milhões de “quadrados” com uma área aproximada de 100 km² espalhados por toda a área da superfície terrestre). Por isso, escalonar processos é essencial para conferir maior precisão aos modelos climáticos. “E apesar do escalonamento, se considera um número maior de processos na modelagem”, lembra Ometto.

Isto revela mais uma diferença entre previsão do tempo e modelagem climática: um número menor de variáveis é considerado crucial no processo de previsão do tempo, se comparado com a modelagem do clima. Níveis de nitrogênio podem não ser essenciais para prever o tempo em curto prazo, por exemplo, mas “fazem parte do processo fotossintético e ignorá-los seria negligenciar parte do processo de modelagem”, conta o pesquisador.

O mesmo é válido para níveis de gás carbônico na atmosfera: não modificam tanto as previsões em curto prazo, mas são uma variável crucial quando se considera o clima dentro de alguns anos ou décadas, por terem impacto sobre mudanças na temperatura global em longo prazo. “O desafio da modelagem”, considera Ometto, “é refletir o maior número de processos críticos na escala em que se está trabalhando”.

E como a definição destes processos pode variar um pouco entre os diversos grupos que trabalham no tema, é compreensível que existam muitos modelos climáticos globais. O professor da UFMG Raoni Rajão considera que, neste quesito, o número de modelos é proporcional ao número de grupos de pesquisa de peso estudando o assunto mundo afora – e estes grupos são proporcionais ao número de pessoas qualificadas que decidem ou precisam trabalhar de maneira independente e conseguem recursos para isso. “É algo que nos diz mais sobre o ecossistema dos cientistas do que o problema científico que eles têm em mãos”, conta.

Rajão considera tal multiplicidade interessante porque, se houvesse mais concentração em um número menor de modelos, haveria uma hierarquização ainda maior no mundo científico: “quanto maior são essas infraestruturas necessárias para produzir os fatos científicos, mais hierarquizado o sistema é”, observa. E completa: “há que se avaliar os prós e contras disso. O filósofo austríaco Karl Popper dizia que a distinção entre ciência e não ciência é que a ciência pode ser falseada. Se todos os recursos e modelos são centralizados num ponto só, como aquilo pode ser falseado?”. Falseabilidade que diz respeito à possibilidade de refutação, critério que guia a definição de cientificidade da ciência moderna.

Marmetria – Fernanda Pestana

Modelagem nacional

A fim de contribuir para a discussão, o Brasil desenvolve, desde 2008, seu próprio modelo climático global, o Modelo Brasileiro do Sistema Terrestre (BESM – da sigla em inglês). A pesquisa integra a Sub-rede de Modelagem Climática da Rede CLIMA, no INPE, e é um dos projetos do Instituto Nacional de Ciência e Tecnologia em Mudanças Climáticas (INCT-MC) e do Programa FAPESP de Pesquisa em Mudanças Climáticas Globais (PFPMCG).

Gilvan Sampaio é um dos coordenadores do projeto e conta que um dos objetivos do BESM é contribuir com a compreensão mais detalhada de fenômenos de maior ocorrência em regiões tropicais, normalmente não tão bem representados nos modelos existentes atualmente. “Comparo um modelo a um carro de corrida da Fórmula-1, por exemplo. No fim de semana em que vai correr, os engenheiros mecânicos fazem ajustes no carro para que ele seja mais eficiente para aquela pista. Um carro que está ajustado para correr em Interlagos, se colocado para correr numa pista da Inglaterra, vai correr também. Mas um carro igual, ajustado para as condições daquela pista, vai correr melhor”, explica.

Segundo Paulo Nobre, coordenador do projeto que desenvolve o BESM e coordenador geral da Rede CLIMA, com o Modelo Brasileiro do Sistema Terrestre, os biomas tropicais e o oceano Atlântico tornaram-se elementos relevantes na contribuição brasileira para o quadro mundial das pesquisas em modelagem climática. Mas este, apesar de ser um objetivo importante ainda não é o principal. O mais importante, segundo ele, é a criação de uma nova cultura, na qual políticos, administradores e o conjunto da sociedade civil se apropriem do que esta ferramenta produz para avaliar o mundo mais criticamente.

Isto, segundo Nobre, também inclui a formação de uma nova classe de cientistas, de todas as áreas do conhecimento, que dominam a compreensão do modelo e o utilizam com a autonomia de quem usa uma caneta, capazes de fazer conexões entre a pesquisa que desenvolvem e as mudanças no cenário global, “sem a necessidade de se tornar cientistas de modelagem do clima”.

Marmetria – Fernanda Pestana

Supermáquinas, complexidade e estabilização de fatos científicos

Há que se destacar, também, que todas as variáveis consideradas em modelagens climáticas, desde a velocidade dos ventos à interação entre temperatura oceânica e gelo em altas latitudes, são representadas por elementos matemáticos ajustados em equações que interagem entre si – e por isso demandam computadores de alta capacidade de processamento. Sobre isto, Nobre ressalta que “o problema das mudanças climáticas é de tal complexidade matemática que nenhum país isoladamente tem a capacidade de resolver”. Daí a necessidade de múltiplos modelos e máquinas de alto desempenho para desenvolvê-los.

Dada a capacidade de processar e armazenar uma quantidade massiva de dados, essas máquinas são apelidadas, não por acaso, de “supercomputadores”. Segundo Pedro Leite da Silva Dias, diretor do Laboratório Nacional de Computação Científica (LNCC), a modelagem climática tem uma relação estreita com o uso de supermáquinas. “Na distribuição das máquinas dos grandes centros de computação no mundo, grande parte das mais potentes estão a serviço de previsão de tempo ou da geração de cenários climáticos futuros”, conta ele.

Isto porque, para emular regras usadas para elaborar estes modelos, como as que regem a movimentação das massas de ar e conservação de energia, são necessárias equações numéricas bastante complexas. “Tipicamente, o número de variáveis em um modelo mais complexo é de 109, ou um bilhão”, conta. E como os cálculos não podem demorar anos para serem feitos, é necessário o uso de computadores com alta capacidade de processamento.

Os supercomputadores mais potentes que existem, conta Dias, operam na escala de petaflops – melhor dizendo, na casa dos quadrilhões de operações por segundo, ou 1015 operações – e têm instalados em média algumas dezenas de milhares de núcleos de processamento (um laptop doméstico, do tipo QuadCore, tem quatro processadores). Seu emprego, para além das modelagens climáticas, inclui aplicações no desenvolvimento de novas drogas na indústria farmacêutica, na descoberta de novos reservatórios de petróleo e na gestão dos já existentes, bem como na modelagem de patologias na pesquisa biomédica, simulações em neurociência, astronomia e física de materiais. As aplicações são muitas.

Quase metade das máquinas de alta performance do mundo (46%) estão nos Estados Unidos, seguidos pela China, com cerca de 15% delas. Reino Unido, Japão, França, Alemanha e Canadá também têm relevância na supercomputação mundial. Entre as marcas que mais investem neste tipo de computação estão as norte-americanas Cray, HP, IBM e Dell; as japonesas Fujitsu e Hitachi e a francesa Bull. Na China, destaca-se a Universidade Nacional de Tecnologia da Defesa (NUDT, na sigla em inglês).

A relação entre desenvolvedoras de computadores de alto desempenho e governos de países, ressalta Dias, sempre foi muito próxima, já que se trata de um investimento bastante alto e de natureza contínua. “As empresas privadas consomem alguma parte da produção mundial, mas os governos são os maiores clientes das desenvolvedoras de supercomputação”, conta.

A maior supermáquina do mundo, por exemplo, é a chinesa Tianhe-2 e está localizada no Centro Nacional de Supercomputação em Guangzhou, no sul do país. Ela tem cerca de 3 milhões de núcleos de processamento e pode realizar mais de 33 quadrilhões de operações por segundo (“flops”), ou seja, ela tem capacidade de operação de 33.84 petaflops (sendo que “peta” é um prefixo binário para designar uma ordem de grandeza um milhão de vezes maior que um “giga”). A Tianhe-2 tem quase o dobro da capacidade de sua congênere norte-americana Titan, que, capaz de operar a 17.59 petaflops, é a segunda colocada na lista dos maiores supercomputadores da atualidade. Localizado no Laboratório Nacional de Oak Ridge (ORNL, na sigla em Inglês), no estado do Tenessee, nos EUA, o supercomputador também é administrado por um órgão estatal, o Departamento de Energia dos Estados Unidos.

Dias conta que, do Brasil, figuram apenas quatro máquinas na lista das 500 maiores do mundo. Duas estão na Petrobras, no Rio de Janeiro; uma no INPE, em Cachoeira Paulista; e uma no Campus Integrado de Manufatura e Tecnologia do Serviço Nacional de Aprendizagem Industrial (SENAI-CIMATEC), em Salvador. No entanto, o país tem outras máquinas de alta performance distribuídas em centros como o LNCC, especializado em computação científica para áreas diversas como ciência atmosférica, biologia computacional e bioinformática.

O supercomputador dedicado exclusivamente para realizar modelagens climáticas no Brasil, localizado no INPE, é um Cray XE6, com cerca de 30 mil núcleos de processamento e capacidade de realizar mais de 250 trilhões de operações por segundo (250 teraflops). Ele foi desenvolvido pensando nas equações e algoritmos usados para o Modelo Brasileiro do Sistema Climático Global.

De acordo com Benjamin Preston, um dos coordenadores do Climate Change Science Institute no ORNL, o desenvolvimento destes computadores de alto desempenho vem antes da criação das equações empregadas para as modelagens que se faz com estas máquinas. No desenvolvimento de um computador como o Titan, a primeira coisa que se tem em mente não é necessariamente a aplicação: “a motivação é expandir as fronteiras em termos de supercomputação. Uma vez que se tem a máquina, a pergunta se torna ‘como podemos usar isto para a ciência que queremos fazer?’. Por isso, um dos desafios que emerge para quem trabalha com modelagem é a necessidade de atualização constante dos modelos, a fim de que funcionem nos novos supercomputadores”.

Marmetria – Fernanda Pestana

Discurso, interpretação, legitimidade

Assim, à medida que a instrumentação muda, também mudam os problemas de pesquisa, e surgem novos discursos, que se utilizam da complexidade de seus cálculos e desenvolvimento para tornar seu discurso legítimo.

Rajão conta que a estabilização de um fato científico se dá por meio de uma cadeia de inscrições feitas por atores humanos e não-humanos (como os equipamentos que coletam dados) que formam uma sequência emaranhada, uma rede, até se estabelecer um fato. “O elo mais fraco da rede são, claro, pessoas. Neste processo, máquinas são mais difíceis de questionar”.

Supercomputadores, gráficos, equações e algoritmos são instrumentos usados para estruturar esta rede de sentidos, que, para ser desestabilizada, levaria um esforço maior ou igual ao empregado para construí-la. “Para isto seria necessário fazer o que o filósofo francês Bruno Latour chama de ‘montar um contra-laboratório’: criar um instituto de peso, capaz de gerar dados científicos com maior precisão e densidade que os dos laboratórios que vêm trabalhando as questões climáticas há décadas”. Isto empregaria um grande esforço – inclusive financeiro – para ser levado a cabo. Rajão lembra que “por isto Latour diz que este emaranhado de sentidos está disposto de tal maneira que não se consegue desestabilizar esta rede nem mesmo quando ela é atacada no seu ponto mais fraco”.

Se do ponto de vista científico é difícil desestruturar as redes de estabilização de um fato, isto não quer dizer que, também do ponto de vista científico, este emaranhado não consiga ser perturbado. E isto não diz respeito apenas à incerteza que envolve a complexidade de modelos climáticos ou a necessária multiplicidade de modelagens. Diz respeito também às diferentes posições de pesquisadores diante de questões como optar por se trabalhar com explicações mais simples ou mais complexas. “Às vezes, as soluções mais simples são as melhores, mas não são as mais legítimas perante a comunidade científica porque o avanço do conhecimento já está em outras direções”, conta Rajão. “Pode ser que um escalonamento que utiliza regras de progressão linear simples se aplique melhor a determinados modelos que equações muito complexas”, comenta.

Aristóteles não acreditava que os ventos eram ar em movimento, ou sistemas dinâmicos. Isso levou com que muitas de suas predições estivessem equivocadas em sua Metereologica, em 340 a. C. Porém, as ideias do filósofo foram utilizadas por quase dois milênios em calendários agrícolas e outros sistemas do mundo ocidental, até que Nicolas Cusa, em meados do século XV, desenvolveu o higrômetro, um sensor que mede a umidade na atmosfera. Este foi o primeiro instrumento meteorológico de que se tem conhecimento no ocidente. Dos instrumentos de observar o tempo às tecnologias de prever o clima, a questão tem se tornado cada vez mais complexa: como calcular algo aparentemente tão imprevisível quanto os fenômenos do tempo?

Dois séculos depois de Cusa, veio à tona uma abordagem um pouco mais precisa da questão, que não era sobre calcular algo que não fosse passível de medições: antes, era sobre como fazê-las e deduzir cálculos a partir delas. À instrumentação nascente somava-se o desenvolvimento do barômetro de mercúrio (construído pelo matemático italiano Evangelista Torricelli em 1643), e o aperfeiçoamento do termômetro, que havia sido prototipado por Galileu na primeira década de 1600. A formulação de teorias, métodos de cálculo e leis (como a da pressão atmosférica de Robert Boyle) que se seguiram pelos séculos 18 e 19 também tiveram papel importante na definição do campo, então incipiente, das ciências climáticas.

Com uma instrumentação disponível mais variada, a meteorologia conseguiria, assim, ser capaz de elaborar um conjunto mais coeso de observações e, consequentemente, de predições – cujo desenvolvimento numérico se deu no início do século 20, em 1904, pensado pelo físico norueguês Vilhelm Bjerknes e desenvolvido pelo matemático britânico Lewis Fry Richardson. À época, Richardson levava meses para produzir uma previsão do tempo de seis horas, nem sempre acurada; hoje, máquinas de centros como o Instituto Nacional de Pesquisas Espaciais (INPE), no Brasil, conseguem fazer uma previsão da evolução do clima durante um ano em seis horas.